Courrier des statistiques N4 - 2020

Des modèles de microsimulation dans un institut de statistique Pourquoi, comment, jusqu’où ?

Les modèles de microsimulation sont incontournables pour l’analyse des politiques

de transferts sociaux et fiscaux. Il peut s’agir de modèles statiques, centrés sur

l’effet des transferts à date donnée, ou bien dynamiques, ce second type de modélisation

s’imposant pour les politiques dont les effets se déploient dans la durée, comme le

font les réformes des retraites.

Si l’usage de ces modèles est très répandu, il n’est pas systématique de les voir

mis en oeuvre dans des instituts de statistique. Le développement de ces outils au

sein de l’Insee s’explique par le fait que l’institut est non seulement producteur

de données brutes mais aussi producteur d’études et de projections. Analyser les politiques

de redistribution et en prévoir l’impact à long terme est donc tout à fait dans ses

missions.

Mais la microsimulation présente également des synergies intéressantes avec la production

statistique proprement dite. On propose aussi quelques pistes de développement pour

consolider la place de ces modèles au sein de l’ensemble des outils d’évaluation des

politiques publiques.

- La microsimulation : deux grandes catégories de modèles

- Pourquoi le recours à ces méthodes ?

- Le recours à la microsimulation dynamique s’est petit à petit imposé

- Pourquoi dans un institut national de statistique ?

- Encadré 1. Destinie : trois apports à l’analyse du système de retraite

- Le « comment » : quelles sources ?...

- Encadré 2. La question de la cohérence avec les projections agrégées

- ...et quels outils informatiques ?

- La microsimulation à l’Insee : jusqu’où ?

La microsimulation : deux grandes catégories de modèles

Il y a maintenant plus d’une vingtaine d’années que le recours à la microsimulation s’est développé à l’Insee, et son usage s’est aussi répandu dans une partie du système statistique public et d’autres administrations proches de l’Insee, principalement dans le domaine social. S’agissant de l’Insee, deux modèles coexistent et ont chacun su accéder à une forte notoriété dans leurs champs respectifs : le modèle Ines, appliqué à l’étude des transferts fiscaux et sociaux, et le modèle Destinie, spécialisé sur le domaine des retraites et autres sujets impactés par le vieillissement de la population (Ouvrir dans un nouvel ongletBardaji et alii, 2003 ; Ouvrir dans un nouvel ongletBlanchet et alii, 2011). Ces modèles sont représentatifs de deux types de microsimulation, la microsimulation statique pour Ines, la microsimulation dynamique pour Destinie.

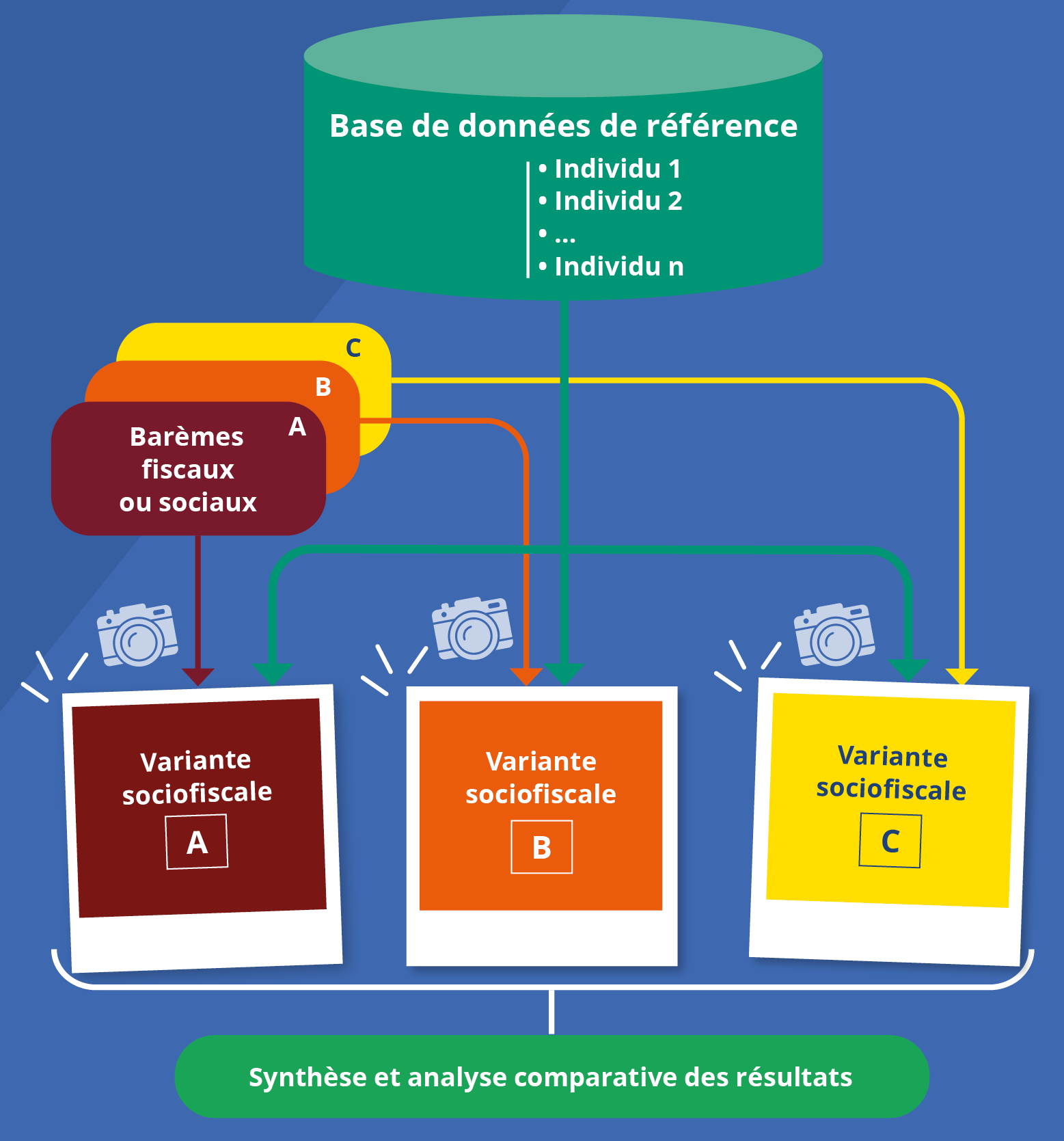

Que recouvrent ces deux termes ? La microsimulation statique appliquée à la fiscalité ou aux transferts sociaux, c’est s’appuyer sur un fichier de données individuelles à date donnée et appliquer aux revenus de ces individus les formules de calcul des prélèvements ou transferts fiscaux et sociaux. On chiffre ainsi à la fois qui sont les contributeurs ou bénéficiaires in fine de ces transferts et comment leurs profils évolueraient suite à des modifications de ces transferts. Dans sa forme la plus élémentaire, la démarche consiste donc uniquement en l’application comptable de barèmes réglementaires, ce qui n’empêche pas ces modèles d’être lourds à construire et à manipuler. Ils peuvent éventuellement être enrichis par la prise en compte de réponses comportementales à ces changements de règles, par exemple des modifications de l’offre de travail – on y reviendra en conclusion –, mais l’optique reste néanmoins une approche de statique comparative : on compare des photos de l’état du monde avec ou sans ces changements de politique (figure 1).

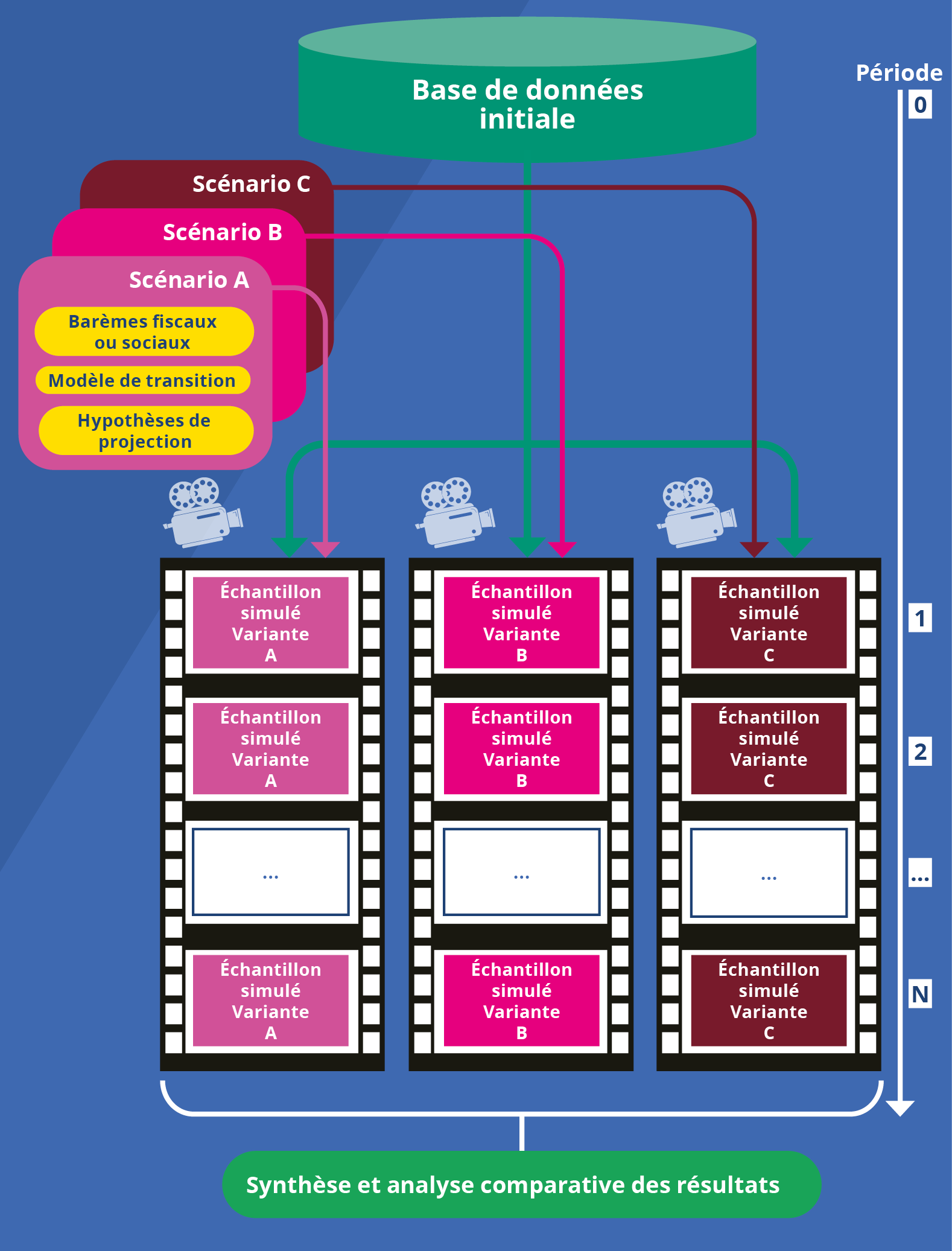

La microsimulation dynamique part du même genre de photo de groupe instantanée, mais la photo n’est que la première image d’un film au cours duquel les positions des individus vont évoluer, incluant la disparition de certains d’entre eux par décès et l’apparition de nouveaux individus assurant le renouvellement de la population simulée, comme dans la vraie vie (figure 2). C’est ainsi que Destinie et les autres modèles de même type simulent le vieillissement des personnes déjà retraitées, l’avancée dans la carrière d’actifs qui deviennent retraités à leur tour, et l’arrivée de nouveaux cotisants. Il le fait à coup d’hypothèses sur les comportements démographiques, les mobilités salariales et les changements de statut sur le marché du travail ainsi que sur les comportements de départ en retraite, en appliquant des cadres législatifs qui peuvent être ceux issus des réformes des retraites déjà actées, ou de nouveaux scenarii de réforme.

Figure 1. La microsimulation statique appliquée à la fiscalité ou aux transferts sociaux

Dans une microsimulation statique, on compare des « photos » de l’état du monde avec ou sans changements de politique.

Figure 2. La microsimulation dynamique appliquée à la fiscalité ou aux transferts sociaux

Dans une microsimulation dynamique, on visualise l’évolution de la population échantillonnée sur une période. Les différents scenarii du modèle déterminent ainsi autant de versions des « films » qu’on pourra comparer ou synthétiser.

Pourquoi le recours à ces méthodes ?

De telles techniques sont mobilisées dans de nombreuses disciplines : démographie, épidémiologie, modélisation des systèmes urbains ou de réseaux de transports, etc. Dans le domaine économique et social, la paternité de l’idée est en général attribuée à Guy H. Orcutt, plus connu des économètres pour la méthode de correction de l'auto-corrélation qui porte son nom, mais qui conçoit aussi, dès les années 1950, un projet de modélisation globale qui est d’entrée de jeu de type dynamique : une modélisation représentative de l’ensemble de l’évolution du système socio-économique, celles des individus et des ménages auxquels ils appartiennent, mais aussi celle des entreprises qui les emploient, et même celle des institutions publiques interférant avec les comportements de l’ensemble de ces acteurs (Ouvrir dans un nouvel ongletOrcutt, 1957). L’idée était de se démarquer des modèles macroéconomiques qui commençaient alors à se développer, en rappelant les limites de leurs raisonnements en termes de grandes catégories d’agents représentatifs.

L’objectif d’Orcutt était très ambitieux pour l’époque. Il a essayé de lui donner corps tout au long de la suite de sa carrière (Ouvrir dans un nouvel ongletWatts, 1991) mais ce sont surtout les modèles statiques qui ont d’abord connu le plus fort développement. Leur utilité pour l’analyse des politiques de transferts fiscaux et sociaux va en effet de soi. On y est d’ailleurs souvent venu spontanément d’une manière totalement indépendante des propositions d’Orcutt. Dans ce domaine, l’approche agrégée des modèles macroéconomiques n’est certes pas sans intérêt, bien au contraire : ils permettent d’explorer l’impact de transferts de structure pas trop complexe, avec l’avantage de prendre en compte les effets d’équilibre général, tels que l’impact des transferts sur l’équilibre offre-demande ou sur le marché du travail. Mais ils ne seront jamais en mesure de simuler les effets détaillés de politiques dont les règles dépendent d’un grand nombre de caractéristiques individuelles, très souvent non linéaires, par exemple en raison d’effets de seuil ou de plafond ; le barème de l’impôt sur le revenu constitue l’exemple typique bien connu de tous. C’est cela que les modèles de microsimulation statique permettent de faire.

Ils auront pour limite symétrique de proposer des analyses en équilibre partiel, car ce qui y arrive à chaque agent est supposé sans effet sur les autres agents et donc sur le reste de l’économie. Mais au moins permettent-ils d’avoir des évaluations précises de ces effets dits « de premier tour », avant bouclages ou réactions comportementales. On ajoute que ce qui justifie ce recours à la microsimulation n’est pas uniquement l’intérêt pour les effets redistributifs : il est tout aussi nécessaire pour un chiffrage précis des coûts ou des bénéfices budgétaires globaux de ces politiques.

Les motivations ont été les mêmes pour la construction de modèles dynamiques appliqués aux retraites, Destinie n’ayant fait qu’embrayer sur une pratique déjà répandue dans d’autres pays. Projeter le financement d’un système de retraite et ce qu’il offre comme droits est possible sans descendre à un niveau de granularité très fin, tant qu’on est dans un travail de dégrossissage consistant à envisager à grands traits les conséquences du vieillissement démographique. C’est ainsi qu’on avait procédé jusqu’au début des années quatre-vingt-dix, période de la rédaction du Ouvrir dans un nouvel ongletLivre blanc sur les retraites (Le Livre blanc sur les retraites d’avril 1991 présentait l’ensemble des régimes de retraite, leurs perspectives d’évolution ainsi que des propositions pour gérer les effets du vieillissement démographique), avec des modèles consistant à plaquer une représentation simplifiée du système de retraite sur des projections démographiques de type traditionnel qui ne désagrègent la population que selon les deux critères de l’âge et du sexe. Procéder ainsi était suffisant pour simuler les effets globaux du vieillissement sur l’équilibre des retraites ou celui de décalages d’ensemble de l’âge du départ en retraite.

Mais la réforme de 1993 qui a commencé à répondre aux questions soulevées par ce Livre Blanc a obligé à changer d’échelle. Comment simuler en effet l’impact d’un calcul de la retraite sur les 25 plutôt que les 10 meilleures années sans raisonner individu par individu, compte tenu des effets très variables qu’a cette règle selon les types de carrière ? Et comment simuler l’impact du passage de 37,5 à 40 années de cotisation pour l’obtention du taux plein, sans connaissance de la distribution détaillée des durées cotisées à l’intérieur de chaque génération ? Multiplier l’examen de cas-types n’aurait fourni que des réponses partielles.

Le recours à la microsimulation dynamique s’est petit à petit imposé

Répondre à ces questions par le recours à la microsimulation n’a pas été sans susciter certaines réticences. On a pu notamment s’inquiéter de la complexité et donc du manque de transparence de ce type d’outils. On a pu aussi s’inquiéter de voir la prospective s’appuyer sur des modèles aux résultats affectés d’un bruit stochastique. La microsimulation dynamique c’est en effet faire évoluer les situations d’un échantillon d’individus à coup de tirages aléatoires selon les probabilités spécifiées par le modèle, puis faire confiance à la loi des grands nombres pour considérer que les résultats auxquels on arrive donnent une bonne image des évolutions à des niveaux plus agrégés, mais qui sera fatalement affectée d’un aléa de simulation qui n’existe pas dans les modèles déterministes agrégés.

Face à cette dernière réticence, on a pu faire valoir que cette forme d’imprécision était bien inférieure aux autres sources d’incertitude qui affectent toute projection de long terme. Il y avait du reste un peu de paradoxe à redouter cet élément d’aléa du modèle alors que nous sommes tout à fait habitués à ce que l’observation du présent soit elle aussi sujette à fluctuation d’échantillonnage : on admet que le taux de chômage courant ne soit mesuré qu’à quelques décimales près, pourquoi cette même marge d’imprécision aurait-elle été intolérable pour des projections des dépenses de retraite à 2040 ? Quant au défaut de transparence, les modèles ainsi construits sont certes difficilement appropriables, et le reproche d’opacité n’est donc pas totalement infondé. Mais c’est oublier que la transparence apparente des modèles plus simples se paye d’un grand nombre d’hypothèses simplificatrices aux conséquences tout aussi peu transparentes : l’individu représentatif des modèles macroéconomiques est une abstraction qui, à l’usage, peut se révéler bien plus opaque que le fait d’agréger les simulations de milliers d’individus qu’on s’est efforcé de faire ressembler le plus possible aux individus du monde réel.

Au final la pratique a donc fini par être acceptée et assumée. À la question du « pourquoi » de la microsimulation, la réponse est tout simplement qu’il n’y a pas d’autre façon de procéder pour modéliser des systèmes complexes.

Mais ceci ne répond pas à la question du « pourquoi dans un institut de statistique ? ». Car d’autres lieux d’accueil naturel existent pour ce genre d’exercice, qu’il s’agisse du monde de la recherche, ou des administrations en charge des programmes sociaux concernés, pour leurs besoins de gestion de court-terme et de prévision à long terme.

Pourquoi dans un institut national de statistique ?

De fait, la microsimulation s’était aussi développée dans ces autres lieux avant d’arriver à l’Insee, et elle a continué de s’y développer après (sur tout cet historique voir (Legendre, 2019), on y renvoie pour des références bibliographiques plus systématiques sur l’ensemble des modèles cités dans cet article) :

- en matière de microsimulation statique avait préexisté la double expérience du modèle Sysiff au Delta (Bourguignon et alii, 1988) et du modèle MIR à la direction de la Prévision. Sysiff peut être vu comme l’ancêtre du simulateur fiscal de Landais, Piketty et Saez devenu le modèle TaxIPP de l’Institut des Politiques Publiques (IPP) (Ouvrir dans un nouvel ongletLandais et alii, 2011). La tradition initiée par MIR s’est poursuivie au Trésor, qui dispose actuellement du modèle Saphir, et la Caisse Nationale d’Allocations Familiales a développé et longtemps exploité son propre modèle, Myriade, avant de finalement se joindre au développement et à l’utilisation d’Ines (voir l’article de Simon Fredon et Michael Sicsic) ;

- côté microsimulation dynamique, c’est plutôt l’Insee qui a été précurseur pour la France, mais la technique s’y est depuis propagée : dans un premier temps à la Caisse Nationale d’Assurance Vieillesse avec le modèle Prisme (Ouvrir dans un nouvel ongletPoubelle et alii, 2006), puis à la Drees avec le modèle TRAJECTOiRE (voir l’article de Pierre Cheloudko et Henri Martin) et au Trésor avec le modèle Aphrodite, avant que d’autres caisses n’emboîtent le pas (le modèle Pablo du Service des retraites de l’État, le modèle Canopée développé par la Caisse des dépôts et consignations pour la CNRACL, et également un modèle en cours de développement à l’Agirc-Arrco), et enfin que le monde académique ne s’y lance également, avec le modèle PensIPP de l’IPP.

Dans la plupart des pays étrangers, c’est plutôt dans ces deux types de cadres, universitaire ou administratif, que se sont développés ces modèles.

Pourquoi une exception française ? Signalons pour être exact que l’exception n’est pas totale. La microsimulation s’était aussi développée à Statistique Canada, et à Statistics Norway. Dans le cas de la France et de la Norvège, cette originalité s’explique évidemment par le fait que les instituts nationaux statistiques (INS) des deux pays ont pour caractéristique de combiner les fonctions de production statistique et d’étude. On peut donc considérer que la microsimulation s’est développée à l’Insee dans le cadre de sa mission d’études et de diagnostic.

Mais l’argument doit être précisé et complété, car on a bien compris de tout ce qui précède qu’un usage assez dominant des modèles de microsimulation est la simulation ex ante de réformes, avec une mobilisation directe pour la préparation des politiques économiques. Or il s’agit d’un terrain sur lequel la statistique publique s’interdit en principe d’intervenir : son rôle est d’analyser et de décrire ce qui est ou a été, pas de dire ou de participer à la conception de ce qui devrait être. Ceci doit-il fragiliser la place qu’y ont acquise ces modèles de microsimulation ?

Plusieurs arguments plaident en sens inverse. Ils viennent très facilement à l’esprit pour la microsimulation statique. Ce n’est certes pas l’Insee qui est en charge de simuler les réformes fiscales à venir. L’institut évite même d’intervenir trop précocement sur les mesures les plus récentes. Mais, pour sa mission de diagnostic sur l’évolution de la société française, il a besoin d’évaluer ce qu’a été l’incidence des mesures passées.

Or la microsimulation est un outil qui sert aussi bien à l’évaluation ex ante qu’à tous les types d’évaluations ex post, à chaud comme à froid. C’est par la microsimulation qu’on est le plus facilement en mesure de retracer en détail ce qu’a été la contribution des mesures fiscales ou sociales passées au niveau de vie des différentes catégories de population. Elle peut le faire de manière précise lorsqu’on a des données microéconomiques complètes sur les revenus avant transferts, et elle permet aussi de le faire de façon avancée avant que ces données détaillées ne soient totalement disponibles. C’est de cette façon qu’Ines a permis de répondre à la demande d’indicateurs avancés de la répartition des revenus et du taux de pauvreté. Le recours à la microsimulation apparaît ici comme un instrument parmi d’autres de la production statistique. On peut la voir comme une extension de la pratique de l’imputation qui est utilisée pour combler les lacunes temporaires ou définitives de l’observation directe. On peut tout aussi bien y voir l’application à la statistique sociale de l’approche par modèles, mobilisée de longue date pour l’estimation avancée des comptes nationaux : dans un cas comme dans l’autre, c’est le terme de nowcasting qui désigne cette pratique de combiner informations partielles et modèles pour donner de premières estimations de ce qui est en train de se produire.

L’argument peut sembler moins convaincant pour la microsimulation dynamique et la projection des retraites. Là, on est clairement dans l’exploration du futur et même d’un futur très lointain. Il se trouve néanmoins que l’exploration du futur fait elle aussi partie du portefeuille d’activités de l’Insee, ou tout du moins de certains aspects de ce futur.

Il y a des domaines dans lesquels cette exploration du futur ne se hasarde pas au-delà du très court terme, celui qui est couvert par la Note de conjoncture, parce que l’institut considère que ses outils ne lui permettent pas mieux que de la prévision à six mois, pour des variables qu’on sait affectées d’une forte volatilité.

Mais les phénomènes démographiques sont caractérisés par une bien plus forte inertie et répondent à une logique très mécanique qui rend tout à fait possible la prévision de long terme, ou plus exactement la réalisation de « projections », c’est-à-dire la simulation de comment sont appelés à évoluer l’effectif total et la structure de la population selon que c’est tel ou tel scénario de mortalité, de fécondité et de flux migratoire qui serait appelé à se réaliser.

Sur le fait de pratiquer ce style de prévision, l’Insee n’est pas du tout dans l’exception : c’est dans les INS que sont la plupart du temps réalisées les projections démographiques des États membres de l’Union européenne. Il y a par ailleurs longtemps que l’Insee a pris l’habitude de compléter ses projections de population totale par des projections de population active.

Ce que fait Destinie vient donc assez naturellement dans le prolongement de ces exercices très standard, il alimente même le second des deux pour ce qui concerne la projection des comportements d’activité aux âges élevés. Pendant longtemps, celle-ci a été faite comme pour les autres tranches d’âge, par extrapolation logistique des chroniques de taux d’activité passée. Cette méthode est devenue clairement inadaptée une fois enclenché le processus de durcissement des conditions d’âge ou de durée pour la liquidation de la retraite. Il fallait trouver une façon de modéliser comment ces révisions avaient commencé et allaient continuer à affecter les comportements de départ en retraite. On retombe sur la raison citée en introduction pour expliquer comment le recours à la microsimulation s’est imposé pour l’ensemble des travaux sur les retraites. L’impact des règles très complexes d’ouverture des droits ne peut être évalué que par des modèles qui prennent en compte le détail des situations individuelles. Ceci ne veut pas dire que ces modèles détiennent forcément la vérité sur les comportements futurs, mais au moins mobilisent-ils le maximum de l’information qui est disponible ou raisonnablement projetable.

Ce faisant, on dispose d’un outil qui permet de répondre à bien d’autres questions, et qui reste dans le champ de la mesure sans se hasarder du côté de la préconisation (encadré 1). Utiliser Destinie pour prévoir l’évolution des niveaux de vie relatifs des ménages de retraités et sa dépendance aux hypothèses de croissance économique, ce n’est pas contribuer à l’élaboration des réformes futures, c’est éclairer sur les effets de réformes déjà actées. Utiliser les trajectoires individuelles que le modèle est amené à reconstituer pour évaluer les propriétés redistributives intragénérationnelles du système actuel, ce n’est ni plus ni moins qu’une prolongation sur le cycle de vie des exercices d’évaluation de la redistribution instantanée menés en statique par le modèle Ines.

Encadré 1. Destinie : trois apports à l’analyse du système de retraite

Les propriétés redistributives du système de retraite peuvent passer par deux canaux : des mécanismes « non contributifs » dont la redistribution est la raison d’être (minima de pension, validation des périodes de chômage, droits familiaux, etc.) ; ou les effets redistributifs du cœur « contributif » du système : ainsi, la règle des 25 meilleures années est jugée redistributive, car gommant l’impact des accidents de carrière sur le montant des retraites. Destinie fait apparaître une réalité plus complexe (Aubert et Bachelet, 2012). La prise en compte des 25 meilleures années profite surtout aux carrières longues ou ascendantes, qui ne conduisent pas aux retraites les plus petites. Le cœur du système serait plutôt anti-redistributif, a fortiori en tenant compte des écarts d’espérance de vie. Les mécanismes non contributifs amortissent mieux les inégalités accumulées durant la vie active. On a pu quantifier cet effet (Dubois et Marino, 2015) : pour les générations 1960 à 1970, de bas en haut de l’échelle des niveaux d’éducation, le « rendement » de la cotisation retraite serait dégressif de 1,5 % à un peu moins de 1 % pour les hommes, et de 2,5 % à 2 % pour les femmes (les avantages familiaux, des droits à réversion et une espérance de vie plus longue compensent leur désavantage en termes de salaires et de durée de carrière).

Avant la fin des années quatre-vingt, pour revaloriser les retraites ou les salaires entrant dans son calcul, on se référait à l’évolution du salaire moyen. Le passage à l’indexation sur les prix a eu deux effets : les salaires passés représentent un plus faible pourcentage du dernier salaire, faisant baisser le taux de remplacement initial, puis, après liquidation, le niveau de la retraite continue de décrocher par rapport au salaire moyen des actifs. Avec Destinie, on démontre à quel point cela a contribué à stabiliser la part des retraites dans le PIB (Marino, 2014) : d’environ 11 % au début des années quatre-vingt-dix, elle serait passée à 20 % en 2040 sans aucune réforme. L’indexation prix a rabattu le point d’arrivée de la courbe autour de 16 %. Mais elle génère une dépendance nouvelle aux hypothèses de croissance : si celle-ci redevenait très rapide, les retraites décrocheraient de beaucoup en proportion des salaires. À l’inverse, une productivité et des salaires réels stagnants rendraient neutre le passage de l’indexation sur les salaires à celle sur les prix. Peut-on trouver des règles d’indexation permettant un pilotage du niveau relatif des retraites qui ne soit pas soumis aux aléas de la croissance économique ? C’est un sujet que Destinie a également exploré (Dubois et Koubi, 2017), ainsi que, hors Insee, le modèle PensIPP (Ouvrir dans un nouvel ongletBlanchet, Bozio et Rabaté, 2016). Avec ou sans mise en place d’un système unifié, la sensibilité du système de retraite aux chocs macroéconomiques va nécessairement être un sujet tout à fait majeur de la période post Covid-19.

La stabilisation de la part des retraites dans le PIB, qui était anticipée avant le choc du Covid-19, devait résulter aussi du recul de l’âge de départ à la retraite (passage de 37,5 à 43 ans de la durée requise pour le taux plein avec les réformes de 1993, 2003 et 2014, et de 60 à 62 ans pour l’âge minimal d’ouverture des droits). Ce recul a déjà conduit à accroître le taux d’emploi des 60-64 ans, et à système inchangé, devait porter l’âge moyen de liquidation aux alentours de 64 ans en 2040. Une autre idée avait guidé l’un des aspects de la réforme de 2003 : la mise en place d’une indexation sur l’espérance de vie, chaque trimestre gagné se répartissant pour deux tiers/un tiers entre durée de la vie active et durée de la retraite. Destinie a servi à confirmer que la mesure ne suffisait pas à stabiliser ce ratio : elle est sans effet pour les individus validant la durée de cotisation requise dès l’âge d’ouverture des droits, ainsi que pour ceux à carrière courte et dans tous les cas contraints de liquider à l’âge maximal. La stabilisation tendancielle du ratio est liée à la remontée à 62 ans de l’âge d’ouverture des droits (Aubert et Rabaté, 2015). Sans autre réforme, le ratio resterait stationnaire dans un premier temps, puis reprendrait sa croissance après la stabilisation à 43 ans de la condition de durée, prévue pour la génération 1970.

Le « comment » : quelles sources ?...

Il y a d’autres recoupements, similitudes et synergies avec l’activité de production statistique. On aborde ici la question du « comment ».

Selon qu’il est statique ou dynamique, un modèle de microsimulation a deux ou trois grandes composantes :

- un ou des modules reproduisant les législations qu’on cherche à simuler ;

- une base de données individuelles ;

- et, dans le cas de la microsimulation dynamique, le ou les modules de projection des situations individuelles, avec leurs paramétrages.

Reproduire les législations à simuler ne relève pas de la compétence statistique proprement dite. À la limite, lorsque c’est possible, un modèle de microsimulation peut directement s’appuyer sur les outils informatiques de calcul des droits utilisés par les administrations en charge d’appliquer ces législations.

Les deux autres volets sont en revanche très adhérents aux travaux de production statistique.

C’est clairement le cas pour ce qui est de la constitution de la base de données de départ. Le développement d’Ines a ainsi été étroitement lié à celui du dispositif statistique sur les revenus fiscaux et sociaux (Il s’agit de l’Enquête sur les revenus fiscaux (ERF), remplacée en 2006 par l’Enquête sur les revenus fiscaux et sociaux (ERFS)), qui a lui-même alimenté les modèles Myriade de la Drees et Saphir du Trésor. Pour les modèles de microsimulation dynamique, la prévision du futur suppose des fichiers comportant suffisamment d’information sur le passé.

La toute première version de Destinie s’appuyait sur l’enquête Patrimoine, seule source qui donnait à l’époque une information rétrospective sur la durée de carrière passée des individus, sous une forme néanmoins assez fruste. Les besoins de Destinie ont pesé en faveur de l’enrichissement de la source avec le recueil d’informations plus détaillées sur l’historique de carrière.

Destinie reste attaché à l’enquête Patrimoine, qui lui donne la possibilité de projeter non pas seulement des individus mais aussi les ménages auxquels ils appartiennent. Pour la projection des droits individuels, l’avantage est cependant du côté des panels administratifs, avec des fichiers bien plus complets et aux données bien plus précises. Le modèle TRAJECTOiRE est ainsi étroitement lié à l’échantillon inter-régimes de cotisants (Ouvrir dans un nouvel ongletEIC) mis au point par la Drees. Avoir un panel qui ne donne que des durées de cotisation passées n’est que d’une utilité très relative pour alimenter les constats sur la retraite, il ne trouve tout son intérêt que prolongé par des durées probables de cotisation futures, pour le calcul des droits afférents : c’est ce que TRAJECTOiRE apporte à l’EIC. En quelque sorte, le modèle est le prolongement logique et nécessaire du panel sur lequel il est basé.

S’agissant ensuite des données de paramétrage de la projection, les données rétrospectives contenues dans le panel de départ peuvent en faire partie : elles informent sur la façon dont les individus se sont comportés dans le passé, ce qui est une base pour la prévision des comportements futurs. Mais le modèle est souvent amené à puiser dans d’autres sources.

Dans Destinie, c’est par exemple de l’enquête Ouvrir dans un nouvel ongletGénération du Céreq et de l’EIC que sont tirées les matrices de probabilités servant à projeter les transitions sur le marché du travail, et c’est sur les données de l’échantillon démographique permanent (EDP) de l’Insee, combinées à celles des enquêtes Famille, Emploi et Formation et qualification professionnelle que sont basées celles qui gouvernent l’évolution des comportements démographiques. Les projections agrégées peuvent aussi alimenter le modèle, à leur façon, si on les utilise comme outils de calage d’une partie de ses résultats, offrant du même coup une solution partielle au problème de l’aléa stochastique (voir supra) associé à un fonctionnement « libre » du modèle (encadré 2).

Encadré 2. La question de la cohérence avec les projections agrégées

Quelles techniques de calage utiliser pour consolider les résultats d’un modèle de microsimulation et garantir leur cohérence avec les prévisions réalisées par des méthodes traditionnelles ? Prenons l’exemple des naissances et d’un modèle appliqué aux retraites :

Des projections démographiques de référence sont établies par la méthode dite « des composants », où le seul prédicteur de l’événement naissance est l’âge de la mère : ces projections déterminent le nombre annuel de naissances comme somme des effectifs féminins par âge, pondérés par les taux de fécondité ;

Dans le modèle de microsimulation, l’âge de la mère sera aussi un déterminant de la probabilité d’une naissance mais, il s’y ajoutera d’autres facteurs explicatifs : le statut matrimonial, le niveau d’éducation et la position sur le marché du travail, le nombre d’enfants déjà eus et la durée écoulée depuis la naissance du dernier d’entre eux. Or rien ne garantit in fine un nombre de naissances cohérent avec celui de la projection usuelle.

Il y a deux écoles face à une telle divergence : soit assumer l’écart en expliquant que, à modèle différent, il est normal d’avoir des résultats différents, soit chercher à éviter les incohérences apparentes. Ceci est possible en contraignant les probabilités conditionnées par les variables individuelles de sorte que, en moyenne, elles donnent le même nombre d’évènements que la projection de référence. On parle alors d’ « alignement ». On considère que le modèle n’est pas forcément plus performant que la projection standard pour donner ce nombre, qui relève d’ailleurs plus de la conjecture que de la prévision : dans le cas des naissances, la projection classique s’appuie sur des hypothèses de fécondité globale ; en revanche, le modèle de microsimulation ventile de manière plausible ces naissances dans la population féminine, en respectant les probabilités relatives d’avoir une naissance selon les caractéristiques des mères.

Le choix entre la simulation libre ou contrainte doit s’apprécier au cas par cas. Dans Destinie, on se cale sur les projections déterministes de population active pour les âges compris entre 25 et 55 ans. En revanche c’est Destinie qui a la main pour évaluer les proportions d’actifs au-delà de 55 ans, ou pour les moins de 25 ans, et c’est la projection traditionnelle qui se cale sur la microsimulation plutôt que l’inverse.

De tels calages apportent une réponse à l’une des réticences à la microsimulation : en contraignant les nombres d’évènements à respecter des cibles macro, on neutralise l’aléa d’échantillonnage et donc le caractère bruité des résultats. Néanmoins le remède doit être appliqué avec précaution. Si le modèle « libre » donne un nombre d’évènements spontanément très éloigné de la cible, forcer ce nombre peut distordre d’autres résultats du modèle non soumis à calage, voire accentuer leur instabilité.

Une façon moins risquée de réduire les biais d’échantillonnage, qualifiée de « réduction de variance », consiste à contraindre le nombre d’évènements simulé à être égal à sa valeur espérée sur la base des probabilités individuelles du modèle, sans l’aléa de tirage spontanément engendré par le modèle.

Enfin en répliquant un grand nombre de simulations indépendantes du modèle et en calculant la moyenne, il est encore plus simple de réduire le caractère bruité du modèle. L’inconvénient du procédé est qu’il démultiplie les temps de calcul, ce qui est plus ou moins bloquant selon la vitesse d’exécution du modèle.

...et quels outils informatiques ?

La question du « comment » est aussi celle des outils informatiques. La capacité limitée des ordinateurs a longtemps empêché d’aller très loin dans la réalisation du programme originel d’Orcutt. C’est bien évidemment de moins en moins le cas, mais d’une façon qui reste très sensible aux solutions logicielles adoptées pour la construction du modèle.

Dans ce domaine, on n’a pas spontanément assisté au développement d’outils dédiés et optimisés comme il a pu s’en développer pour la modélisation macroéconomique ou l’analyse statistique. À ceci une raison très simple : la microsimulation est un exercice qui ne fait pas appel à une technicité très avancée. Une fois réunis et maîtrisés les fichiers de données individuelles, un bon langage généraliste et un générateur fiable de nombres pseudo-aléatoires suffisent pour se lancer dans la construction d’un modèle, le reste n’est qu’affaire de rigueur et de patience. Dans ce contexte, la tendance naturelle du modélisateur est d’opter pour le logiciel ou le langage de programmation dont il est le plus familier, quel qu’il soit.

Pour prendre à nouveau l’exemple de Destinie, il avait été initialement écrit en Turbo Pascal, puis il a tenté un virage avorté vers C++ au début des années deux-mille, à la suite de quoi il s’est ensuite replié sur Perl et a tourné quelques années sous ce langage, avant de basculer vers un mélange de R et de C++. Le passage à R est cohérent avec la place que ce langage est en train de prendre dans l’ensemble de l’Insee. Si R est le langage de référence pour le reste des travaux statistiques et d’études conduits dans l’institut, il est assez naturel d’y recourir aussi pour la microsimulation, évitant aux utilisateurs de devoir maîtriser deux langages. Mais son inconvénient est la plus grande lenteur d’exécution des programmes ; c’est ici qu’intervient la bascule à C++ pour une partie de son code.

L’argument de la rapidité d’exécution avait aussi conduit les concepteurs de Myriade à opter directement pour le même langage C++, néanmoins abandonné depuis avec le ralliement de la Cnaf à Ines : ce modèle est programmé en SAS, tout comme TRAJECTOiRE à la Drees et Prisme à la Cnav. Mais pour Ines se pose maintenant la question d’un basculement à R, comme l’a fait Destinie.

Il est souvent regretté que cette grande variété d’approches conduise beaucoup de modélisateurs à réinventer la roue, voire à la réinventer plusieurs fois lorsqu’ils passent d’un langage à un autre. Même si chaque modèle est spécifique, on se dit qu’il doit en effet exister des briques mutualisables. Les procédures de calage ou d’alignement présentées dans l'encadré 2 en sont un exemple évident, mais il y a eu des tentatives de construire des cadres de programmation plus systématiques, devant permettre au modélisateur de se soucier avant tout du contenu de son modèle en perdant le minimum de temps sur les questions purement informatiques. Statistique Canada avait ainsi développé l’outil ModGen, écrit en C++. De développement plus récent et qui rencontre un certain succès est le progiciel LIAM 2, porté par les microsimulateurs du Bureau belge du plan (Ouvrir dans un nouvel ongletde Menten et alii, 2014). Cette problématique du choix de l’outil de programmation est donc en train d’évoluer.

Comme pour le reste de la production statistique, il y a un équilibre à trouver entre mutualisation et préservation d’un principe de subsidiarité autorisant le modélisateur à choisir ce qui lui paraît le plus adapté pour le modèle qu’il souhaite construire.

La microsimulation à l’Insee : jusqu’où ?

Ayant abordé les questions du « pourquoi » et du « comment », reste celle des perspectives. Y a-t-il de nouvelles directions vers lesquelles faire prospérer ces outils ? Au risque d’un peu d’utopie, on peut revenir au programme originel d’Orcutt, mais aussi développer la question des liens avec d’autres pratiques de l’évaluation des politiques publiques, un sujet auquel l’Insee contribue par d’autres voies que la microsimulation et avec lesquelles des complémentarités pourraient être développées.

Le programme d’Orcutt tout d’abord. La microsimulation dynamique appliquée aux seules retraites n’est qu’un aspect parmi d’autres de ce que pouvait englober ce programme, d’ailleurs probablement pas celle à laquelle Orcutt avait pensé à l’époque. Or il se trouve justement que, sur ce créneau spécifique des retraites, Destinie a perdu une partie de l’avantage que lui avait temporairement procuré son statut de précurseur : il est moins précis que les modèles assis sur les données administratives de la Drees, de la Cnav ou des autres caisses qui se sont lancées dans le même genre de démarche. Il lui reste en revanche l’avantage de simuler des ménages et pas uniquement des individus, ce qui lui permet des calculs de niveau de vie et l’étude de dispositifs conditionnés aux ressources totales de ces ménages, pas seulement de chacun de leurs membres pris séparément. Cette spécificité le rend incontournable pour l’étude de la réversion, et elle est aussi utilisée pour un sujet très lié aux retraites mais néanmoins distinct, celui de la dépendance et de sa prise en charge, pour lesquels la dimension ménage est très importante.

Sans aller jusqu’à la modélisation sociale « totale » qui était envisagée par Orcutt, une voie d’évolution peut donc être de chercher à faire de Destinie un outil de référence pour nourrir la prospective à long terme des niveaux et des conditions de vie, sous un grand nombre d’aspects. Ceci peut se faire par construction progressive de modules additionnels, car un des avantages de la méthode, c’est aussi la possibilité d’y greffer des modules additionnels tirant parti de ce que simule le cœur du modèle et le complétant par la simulation de variables annexes. Un module épargne et patrimoine est ainsi en cours de construction, centré sur le patrimoine financier, auquel un complément naturel serait la simulation du patrimoine immobilier. D’autres thèmes sont envisageables à la commande, par exemple la simulation de l’exposition à la précarité énergétique, déjà traitée au CGDD dans un cadre statique, celui du modèle Prometheus (Ouvrir dans un nouvel ongletThao Khamsing et alii, 2016).

La place de la microsimulation dans l’évaluation des politiques publiques pour finir. Cette place est un peu paradoxale. La microsimulation est par nature une pièce centrale de tout dispositif d’évaluation, ex ante comme ex post, et pourtant peu reconnue par les économistes se réclamant de l’évaluation. Pour une majorité d’économistes du domaine, évaluer une politique publique, c’est mesurer empiriquement son impact sur une ou quelques variables d’intérêt – les outcomes – en s’appuyant dans le cas idéal sur de l’expérimentation contrôlée, ou à défaut sur des quasi-expériences ayant affecté de façon différenciée des groupes de population suffisamment comparables pour pouvoir jouer les rôles de groupe test et de groupe témoin.

Les approches expérimentales ou pseudo expérimentales sont évidemment des aspects importants de l’évaluation, mais les y réduire n’a pas de sens. Toutes les politiques ne sont pas évaluables en ces termes. Privilégier une seule méthode d’évaluation c’est se condamner à ignorer un grand nombre de sujets. Même pour des sujets pour lesquels cette méthode est pertinente, elle ne répond qu’à une partie de la question : savoir que telle incitation financière a modifié l’offre de travail de telle ou telle proportion de personnes n’informe pas à soi tout seul sur le rapport coût-bénéfice de la mesure ou ses effets redistributifs.

Ceci plaide donc pour reconnaître la complémentarité des approches (Ouvrir dans un nouvel ongletBlanchet et alii, 2016). Le reproche régulièrement adressé aux modèles de microsimulation statiques est qu’ils sont le plus souvent purement comptables, sans hypothèses de réactions comportementales. Les modèles de microsimulation dynamique introduisent des comportements, mais souvent très mécaniques ou exogènes, comme lorsqu’ils se bornent à reproduire les probabilités de transitions entre états constatées dans le passé. Il y a donc place pour y mettre des hypothèses de comportement dont le paramétrage se nourrirait des résultats d’évaluations empiriques ex post, mais pas que, car on peut aussi être amené à projeter des réponses comportementales pour lesquelles l’évaluation ex post rigoureuse ne sera pas disponible avant longtemps, voire jamais. L’exemple de l’âge de départ en retraite en est le meilleur exemple : on ne peut pas attendre que les réformes aient produit tous leurs effets sur les âges de liquidations pour intégrer ces effets dans les modèles de projection.

Reste l’ambition d’avoir des modèles qui soient non seulement à comportements endogènes mais qui soient également bouclés. Dans le projet d’Orcutt, la prise en compte du bouclage passait par la récursivité. À la date t, les agents réagissent indépendamment les uns des autres à l’état courant du monde qu’ils constatent autour d’eux, il en résulte à l’instant suivant un nouvel état du monde auquel ils réagissent à nouveau et ainsi de suite. Pour que cela rende compte du monde réel, il suffit de construire des modèles à pas temporel suffisamment fin, quand les moyens de calcul le permettent. Des tentatives ont été faites en France pour appliquer cette logique au fonctionnement du marché du travail (Barlet et alii, 2010 ; Ouvrir dans un nouvel ongletBallot et alii, 2016), tirant la microsimulation vers une autre catégorie de modèles, ceux que la littérature économique préfère qualifier de modèles d’agents, pour bien marquer la différence avec une microsimulation jugée trop comptable.

Il est trop tôt pour dire jusqu’où ce type d’approche serait en mesure de concurrencer la modélisation macro-économétrique traditionnelle, mais les macroéconomistes eux-mêmes sont de plus en plus sensibles à la nécessité de sortir de leurs représentations excessivement agrégées : il n’y a pas que pour les constats statistiques qu’il est nécessaire d’aller au-delà de la moyenne, c’est pour l’ensemble des outils de modélisation que la même question peut se poser.

Paru le :29/06/2020

Ines est l’acronyme d’« Insee-Drees », les deux organismes qui développent conjointement le modèle (la Drees est le service statistique du ministère des Solidarités et de la Santé). Voir l’article de Simon Fredon et Michael Sicsic dans ce même numéro.

Destinie : modèle Démographique Économique et Social de Trajectoires INdividuelles sImulÉes.

Le Livre blanc sur les retraites d’avril 1991 présentait l’ensemble des régimes de retraite, leurs perspectives d’évolution ainsi que des propositions pour gérer les effets du vieillissement démographique.

i.e. le bruit dû au fait que la simulation utilise des répétitions de tirages au sort, qui est davantage que de l’aléa d’échantillonnage stricto sensu.

Sur tout cet historique voir (Legendre, 2019) : on y renvoie pour des références bibliographiques plus systématiques sur l’ensemble des modèles cités dans cet article.

Unité mixte de recherche ENS-CNRS-EHESS.

Voir l’article de Pierre Cheloudko et Henri Martin dans ce numéro.

CNRACL : Caisse nationale de retraites des agents des collectivités locales.

L’Agirc (Association générale des institutions de retraite complémentaire des cadres) et l’Arrco (Association pour le régime de retraite complémentaire des salariés) gèrent des régimes de retraite complémentaires.

L’Insee produit une Note de Conjoncture (mars, juin, décembre) et un Point de Conjoncture (en octobre).

Il s’agit de l’Enquête sur les revenus fiscaux (ERF), remplacée en 2006 par l’Enquête sur les revenus fiscaux et sociaux (ERFS).

L’EIC est un échantillon anonyme d’individus, reconstituant l’intégralité de la carrière année après année par rapprochement des données des différents régimes. Pour plus de détails, voir l’article de Pierre Cheloudko et Henri Martin dans ce même numéro.

Le Centre d’études et de recherches sur les qualifications mène une enquête qui permet de reconstituer et d’analyser les parcours des jeunes au cours de leurs trois premières années de vie active.

Le commissariat général au développement durable (CGDD) relève du ministère de la Transition écologique et solidaire. Il abrite le service des données et études statistiques (Sdes) i.e. le service statistique des ministères chargés de l’environnement, de l’énergie, de la construction, du logement et des transports.

Pour en savoir plus

AUBERT, Patrick et BACHELET, Marion, 2012. Disparités de montant de pension et redistribution dans le système de retraite français. In : L’Économie française – Comptes et dossiers, édition 2012. [en ligne]. 4 juillet 2012. Collection Insee références, pp. 40-62. [Consulté le 24 avril 2020].

AUBERT, Patrick et RABATÉ, Simon, 2015. Durée passée en carrière et durée de vie en retraite : quel partage des gains d’espérance de vie ?. In : PIB par habitant en longue période – Assurance dépendance – Durée de la retraite et espérance de vie – Mesure de la concentration spatiale. [en ligne]. 19 février 2015. Économie et Statistique, N°474-2014, pp. 69-95. [Consulté le 24 avril 2020].

BALLOT, Gérard, KANT, Jean-Daniel et GOUDET, Olivier, 2016. Ouvrir dans un nouvel ongletUn modèle multi-agents du marché du travail français, outil d’évaluation des politiques de l’emploi : l’exemple du contrat de génération. In : Revue économique. [en ligne]. Juillet 2016. Vol. 67, n°4, pp. 733-771. [Consulté le 24 avril 2020].

BARDAJI, José, SÉDILLOT, Béatrice et WALRAET, Emmanuelle, 2003. Ouvrir dans un nouvel ongletUn outil de prospective des retraites : le modèle de microsimulation Destinie. In : Micro-simulation : l’expérience française. [en ligne]. La Documentation française – Économie & prévision, N°160-161, pp. 193-213. [Consulté le 24 avril 2020].

BARLET, Muriel, BLANCHET, Didier et LE BARBANCHON, Thomas, 2010. Microsimulation et modèles d’agents : une approche alternative pour l’évaluation des politiques d’emploi. In : Bas salaire et marché du travail. [en ligne]. 20 août 2010. Économie et Statistique, N°429-430 – 2009, pp. 51-76. [Consulté le 24 avril 2020].

BLANCHET, Didier, BOZIO, Antoine et RABATÉ, Simon, 2016. Ouvrir dans un nouvel ongletQuelles options pour réduire la dépendance à la croissance du système de retraite français ?. In : Revue économique. [en ligne]. Vol. 67, n°2016/4, pp. 879-911. [Consulté le 24 avril 2020].

BLANCHET, Didier, BUFFETEAU, Sophie, CRENNER, Emmanuelle et LE MINEZ, Sylvie, 2011. Ouvrir dans un nouvel ongletLe modèle de microsimulation Destinie 2 : principales caractéristiques et premiers résultats. In : Les systèmes de retraite et leurs réformes : évaluations et projections. [en ligne]. 20 octobre 2011. Économie et Statistique, n°441-442 – 2011, pp. 101-121. [Consulté le 24 avril 2020].

BLANCHET, Didier, HAGNERÉ, Cyrille, LEGENDRE, François et THIBAULT, Florence, 2016. Ouvrir dans un nouvel ongletÉvaluation des politiques publiques, ex post et ex ante : l’apport de la microsimulation. In : Revue économique. [en ligne]. Juillet 2016. Vol. 67, n°4, pp. 685-696. [Consulté le 24 avril 2020].

BOURGUIGNON, François, CHIAPPORI, Pierre-André et SASTRE-DESCALS, José, 1988. SYSIFF: a simulation of the French tax benefit system. In : ATKINSON, A. B. et SUTHERLAND, Holly, 1988. Tax benefit models. Décembre 1988. STICERD Occasional Paper, n°10, p. 395. ISBN : 8-85328-103-3.

DE MENTEN, Gaëtan, DEKKERS, Gijs, BRYON, Geert, LIÉGEOIS, Philippe et O’DONOGHUE, Cathal, 2014. Ouvrir dans un nouvel ongletLIAM2: a New Open Source Development Tool for Discrete-Time Dynamic Microsimulation Models. [en ligne]. 30 juin 2014. Journal of Artificial Societies and Social Simulation (JASSS), n°17. [Consulté le 24 avril 2020].

DUBOIS, Yves et KOUBI, Malik, 2017. Règles d’indexation des pensions et sensibilité des dépenses de retraites à la croissance économique et aux chocs démographiques. [en ligne]. 30 mars 2017. Insee, Documents de travail, n°G2017-02. [Consulté le 24 avril 2020].

DUBOIS, Yves et MARINO, Anthony, 2015. Le taux de rendement interne du système de retraite français : quelle redistribution au sein d’une génération et quelle évolution entre générations ?. In : Microsimulation appliquée aux politiques fiscales et sociales. [en ligne]. 17 décembre 2015. Économie et Statistique, n°481-482, pp. 77-95. [Consulté le 24 avril 2020].

LANDAIS, Camille, PIKETTY, Thomas et SAEZ, Emmanuel, 2011. Ouvrir dans un nouvel ongletLe modèle de micro-simulation TAXIPP – version 0.0. [en ligne]. Janvier 2011. Édition Institut des Politiques Publiques. [Consulté le 24 avril 2020].

LEGENDRE, François, 2019. L’émergence et la consolidation des méthodes de microsimulation en France. In : Numéro spécial – 50e anniversaire. [en ligne]. Économie et Statistique, n°510-511-512 – 2019, pp. 201-217. [Consulté le 24 avril 2020].

MARINO, Anthony, 2014. Vingt ans de réformes des retraites : quelle contribution des règles d’indexation ?. [en ligne]. 15 avril 2014. Insee Analyses n°17. [Consulté le 24 avril 2020].

ORCUTT, Guy H., 1957. Ouvrir dans un nouvel ongletA new type of socio-economic system. In : The Review of Economics and Statistics. [en ligne]. N°39(2), pp. 116-123. [Consulté le 24 avril 2020].

POUBELLE, Vincent, ALBERT, Christophe, BEURNIER, Paul, COUHIN, Julie et GRAVE, Nathanaël, 2006. Ouvrir dans un nouvel ongletPrisme, le modèle de la Cnav. In : Retraite et société. [en ligne]. Juin 2006. La Documentation française, n°48, pp. 202-215. [Consulté le 24 avril 2020].

THAO KHAMSING, Willy, CECI-RENAUD, Nila et GUILLOT, Lola, 2016. Ouvrir dans un nouvel ongletSimuler l’impact social de la fiscalité énergétique : le modèle Prometheus (PROgramme de Microsimulation des Énergies du Transport et de l’Habitat pour ÉvalUations Sociales) – Usages et méthodologie. In : Études et documents. [en ligne]. Février 2016. Service de l’Économie, de l’Évaluation et de l’Intégration du développement Durable (SEEIDD), n°138. [Consulté le 24 avril 2020].

WATTS, Harold W., 1991. Ouvrir dans un nouvel ongletDistinguished Fellow: An Appreciation of Guy Orcutt. In : The Journal of Economic Perspectives. [en ligne]. Winter 1991. Vol. 5, n°1, pp. 171-179. [Consulté le 24 avril 2020].